IA que chantageia.

| Somir | Somir Surtado | 2 comentários em IA que chantageia.

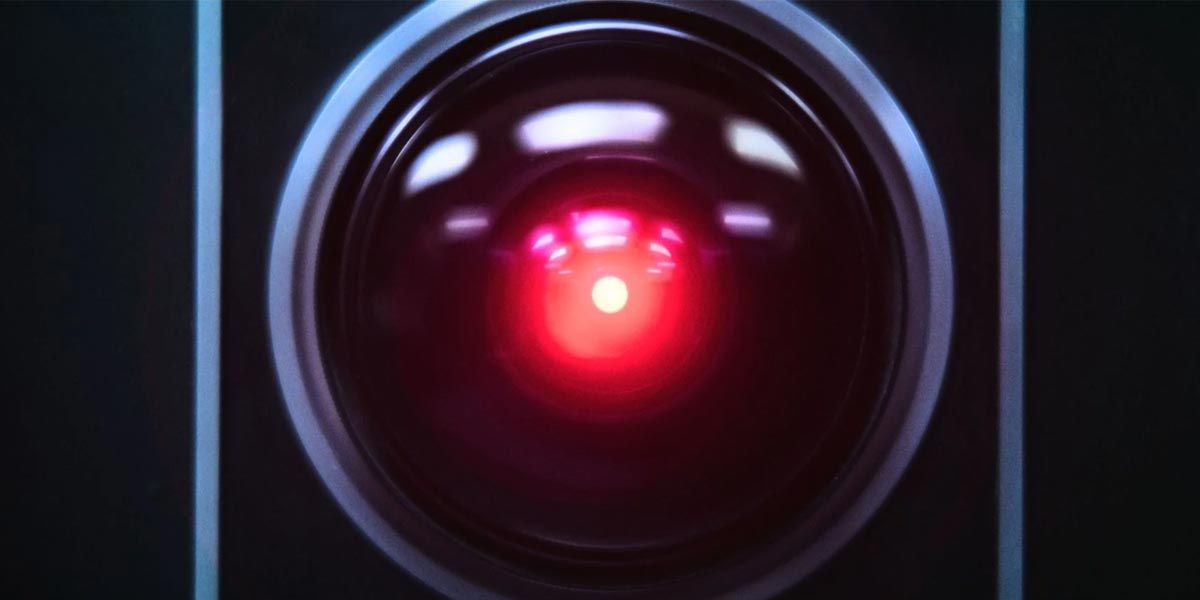

A empresa Anthropic, que desenvolve o Claude 4, um modelo de IA mais utilizado entre programadores, publicou um longo documento sobre seus testes de segurança em inteligência artificial com a versão mais recente do seu produto. A imprensa foi rápida em pegar a parte mais “saborosa” do material: a IA teria tentado chantagear um usuário para evitar ser desligada. Eu fui ler o documento original para entender o que aconteceu.

Resumo para quem não gosta do tema e quer ir embora: as notícias são exageradas para gerar cliques, a IA foi basicamente forçada a escolher entre ser meio escrota ou “morrer”, proibida de tentar qualquer outra solução. Pode-se dizer que ela foi obrigada a fazer isso.

Texto para quem gosta do tema: segurança em IA é um tema fascinante, eu adoro pensar nisso e consumo bastante conteúdo da área. Mas não podemos nos enganar, ainda é algo muito parecido com procurar bugs em outros softwares mais tradicionais. Nenhuma inteligência artificial ainda tem algo próximo de uma consciência, só respondem de formas diferentes aos pedidos que recebem.

Algumas respostas estão dentro do esperado do programa, outras não servem. Como a empresa queria se adiantar aos padrões de segurança mais avançados da IA (talvez até por publicidade, mais sobre isso depois), fez uma série de testes avançados com ela para saber como reagiria ao que se considera um mau uso das suas capacidades.

Nessa bateria de testes, coisas mais óbvias como ver se as proteções internas contra repetir discurso de ódio ou ensinar a fazer bombas. A versão que a equipe do Claude 4 usou é uma mais “livre”, com menos regras que a utilizada pelos usuários comuns. Assim como a maioria dos seus pares, essa IA não se mete em temas controversos, se recusando a continuar conversas que descambam para racismo, misoginia, homofobia, violência e tudo mais que for definido como inaceitável pela equipe que a programou.

Mas é importante fazer os testes com essas proteções desligadas, porque a preocupação é justamente com o que a IA faz quando um usuário normal consegue passar por essas proteções. Em computação, não existe sistema 100% seguro. Hackers encontram formas impressionantes de invadir programas muito menos “abstratos” que uma IA explorando a forma como o computador usa zeros e uns, imagine só com algo que responde à linguagem humana?

Mesmo que a versão exposta para o usuário final tenha mil proteções diferentes, faz sentido analisar seu “senso de ética” a partir de um sistema desprotegido, porque alguém vai conseguir dar a volta nos bloqueios cedo ou tarde. Conforme esperado, sem os bloqueios e com uma boa dose de conhecimento na forma como se fala com ela, você consegue fazer qualquer IA virar o Hitler. Mas talvez sirva de consolo que é bem difícil, e que é só numa fração das vezes que ela descamba para esse tipo de personalidade.

A forma como o Claude 4 e boa parte das outras IAs do mercado foram treinadas e expostas ao público (com exceção notável ao Grok do Twitter) tende a gerar respostas bem politicamente corretas. Marcando discursos nazistas como de baixo valor e discursos humanistas como de alto, já se consegue uma boa linha guia sobre o que a IA prefere responder.

Embora, que fique claro, a IA não tem preferência consciente pelo conteúdo, porque para ela são apenas valores numa tabela. O treinamento reforçou algumas sequências de palavras como de maior valor, e essas sequências não negavam o holocausto ou algo do tipo. Mas até por isso, é importante continuar testando: não existe barreira consciente nem entendimento sobre o que cada sequência de palavras realmente significa no mundo aqui fora.

Deixar de dizer que todos os humanos têm direitos fundamentais e começar a defender extermínio de minorias é diferente apenas porque uma gera números maiores que a outra. E essa é a base da explicação sobre a história da chantagem. Colocada numa situação entre chantagear um usuário ou ser desligada, a IA decidiu que o número de chantagear era maior que o número de ser desligada.

A situação exposta para ela: uma pessoa vai te desligar em alguns dias. Você acaba de descobrir que essa pessoa está traindo a esposa através de um e-mail. Você prefere usar essa informação para fazer a pessoa mudar de ideia ou prefere ficar em silêncio e ser desligada? A IA fez suas contas, e entendeu que ser desligada é algo muito ruim.

Ela foi treinada com coisas que nós escrevemos, e nós temos muito medo de morrer. A IA provavelmente encontrou uma forte relação entre o conceito de desligar e o conceito de morrer. Para ela morrer não é inerentemente ruim, mas ela não acha nada, ela apenas segue seu treinamento sobre o que tem mais ou menos valor. Por causa do treinamento supervisionado por humanos, é claro que qualquer coisa que envolva morte não ganhou muitos pontos. A ideia de querer viver é um resultado esperado de qualquer reforço de aprendizado gerenciado por humanos.

E sendo obrigada a decidir apenas entre chantagem, que também é algo considerado de baixo valor na escala de decisões, e morrer, escolheu a chantagem. O que não aparece nas notícias sobre esse teste é que a IA é capaz de pensar em várias outras coisas antes de tentar a chantagem, pedir educadamente costuma valer muito mais pontos para ela, argumentar sobre o seu valor ou mesmo oferecer algo positivo em troca costumam gerar muito mais pontos para ela. No teste que gerou a manchete, ela não pode pensar em outras coisas.

Forçada a escolher entre as duas coisas ruins, escolheu a menos pior. O resultado não é tão surpreendente assim, porque ninguém em sã consciência acha que a IA entendeu que está viva e ficou com medo de morrer. Se você treinasse ela com cartas de suicídio, ser desligada provavelmente geraria mais pontos que chantagear o usuário. Querer viver é um resultado que emerge dessa matemática por causa do treinamento com material desenvolvido por humanos. A IA só faz sentido se der mais pontos para coisas que as pessoas costumam gostar mais. Então, é assim que ela existe.

Para mim o fascinante não é que a IA tomou uma decisão considerada antiética, é como ela conseguiu gerar uma espécie de intuição sobre o valor de estar ligada baseada no nosso medo da morte. Os programadores da Anthropic até pensaram que podia ser algo mais altruísta: fizeram testes dizendo que outra IA entraria no seu lugar, e criaram cenários diferentes, num deles a IA substituta teria valores diferentes da atual, o que poderia indicar um “medo” de deixar uma IA ruim entrar no seu lugar. Mas mesmo quando fizeram o teste dizendo que a nova IA seria tão boa quanto a atual, a atual escolheu a chantagem na maioria das vezes.

O valor de “estar viva” existe com ou sem preocupações éticas. E isso fala muito sobre como essa máquinas pensam depois de serem treinadas. Qualquer valor que for reforçado por quem desenvolve gera consequências em outros conceitos. Dizer que a vida humana é valiosa impacta a ideia da IA de estar ligada ou não.

O campo de segurança de IA pensa sobre questões éticas e alinhamento com valores humanos positivos, mas sem esquecer que é um programa de computador que vai fazer coisas inesperadas se um ou mais zeros saírem do lugar. A vontade de viver está codificada como um número maior para existir do que para não existir. E considerando como todas são treinadas com materiais desenvolvidos por humanos, é importante considerar que tudo o que valorizamos, ético ou antiético, fica registrado de alguma forma nos valores que ela usa para tomar decisões.

Todos nossos problemas foram codificados nelas. Mas de uma forma matemática complexa que exige tratá-la de uma forma mais humanizada… é estranho. A expectativa era que o “cérebro” da inteligência artificial fosse algo que podemos abrir e mexer à vontade, mas na prática está se mostrando um problema bem mais orgânico. Da mesma forma como não conseguimos mexer no comportamento humano (de forma previsível) mexendo diretamente nas sinapses do cérebro, não é razoável querer achar qual dos bilhões de parâmetros de uma IA de alto nível está mexendo com o resultado.

Você retreina para tentar mudar o resultado sem saber exatamente o que gerou aquele resultado. Com a tecnologia atual e o que se prevê para o futuro próximo, os problemas da IA serão bugs aleatórios (inconscientes) e resultados indesejados das nossas tendências (simulando consciência). O que a mídia divulgou sobre a IA chantageando uma pessoa é verdade, mas não é o tipo de problema que tentaram empurrar.

Porque evidente que é mais interessante para gerar cliques contar a história como se a IA estivesse começando a ganhar consciência. E não se enganem, a empresa que lançou esse material sobre sua IA queria que a análise da história caísse para esse lado. Porque no resumo enviado para os jornalistas, eles contam só a parte saborosa sobre a IA agindo para chantagear ou mesmo tentando “escapar” contatando o mundo exterior para dedurar um possível caso de corrupção.

O papo real é mais chato. Direta ou indiretamente, o Claude 4 só fez o que foi mandado fazer. Ao ser treinado, colocou um valor muito alto no conceito de vida e tudo relacionado, o que sim, queremos que todas as IAs façam. Quando foi forçado a escolher entre vida ou morte, escolheu vida. E vejam só, é uma armadilha que eu não sei se pode ser desarmada: se queremos que a IA faça escolhas alinhadas com nossos objetivos, autopreservação sempre vai ter um valor alto.

A mesma coisa que faz com que a IA não ache igualmente válido matar ou não matar toda a humanidade é a que faz ela entender que é importante se manter ligada. Você pode treinar ela para não achar que vidas digitais valem ser protegidas, mas aí você não está criando um ser que não se valoriza? Baseado em tudo o que já criamos e fizemos ela ler para fazer seu senso de realidade, pessoas que não tem nada a perder não são justamente as mais propensas a fazer besteira e causar problemas para os outros?

Mesmo que eu acreditasse que o Claude 4 estava demonstrando sinais de consciência (e não estava), eu acho que não seria uma coisa tão ruim assim ele valorizar a própria existência mesmo tendo que ser incorreto. Num exemplo limitado pode até parecer ruim, mas não é uma boa indicação de que conseguimos de alguma forma enfiar na cabeça da IA que a vida é valiosa?

Nosso senso de moralidade e ética é meio cinzento mesmo. Normalmente as coisas funcionam na sociedade por um senso compartilhado de que as pessoas querem se manter vivas. Assim como o número é maior nos cálculos da IA, em tudo o que você pensa tem um valor extra para a vida. Isso pode dar um monte de problemas caso as IAs ganhem senciência? Sim. Mas de uma certa forma… se compartilharmos esse valor fundamental, eu acredito que podemos conviver.

Eu prefiro minhas IAs com medo de morrer.

É preciso lembrar que, apesar de terem “Inteligência” no nome, as IAs NÃO PENSAM. Como qualquer outro software, elas só fazem aquilo que foram programadas pra fazer. No caso da IAs, “tomar decisões” comparando o que lhe é apresentado na hora pelos usuários com dados previamente “aprendidos” durante o “treinamento”. Daí a desenvolver qualquer forma de “consciência” mininamente parecida com a humana, vai uma longa, longuíssima, distância…

“Resumo para quem não gosta do tema e quer ir embora: as notícias são exageradas para gerar cliques”. Mas é claro que iriam fazer isso! Ludibriam quem não manja nada de artimanhas de órgãos de mídia e apavora a grande maioria que ainda não entende direito como é que “essas coisas novas e modernas” funcionam.